Kennt ihr eigentlich die Daten-Unterseite von Clubelo? Vielleicht für euch ja interessant:

http://clubelo.com/Data

Kennt jemand zufällig eine Seite, wo ich zu jeder Partie den Field Tilt sehen kann? LG

Mir fällt als erstes dazu der Twitter Account BuLiAnalytics von Ben Griffis ein, der eigentlich zu jedem Spiel Match Sheets postet und dort findet man auch Field Tilt. Ist natürlich nicht so unübersichtlich wie eine Tabelle, in der man alle Spiele findet. Jedoch für bestimmte Spiele kann man recht schnell über die Suche mit den jeweiligen Hashtags die Match Sheets finden oder für bestimmte Vereine mit jeweiligen Vereinshashtags.

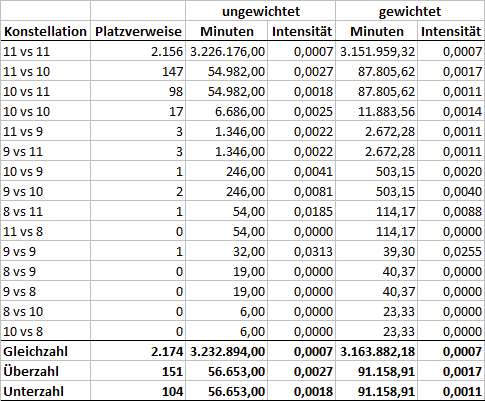

Im Discord tauchte die Frage auf: „Gibt es häufiger einen Platzverweis, wenn der Gegner in Unterzahl spielt?“ (Möglicherweise im Zusammenhang mit der Sendung zum 25. Spieltag von 10. März, aber das ist schwer rauszufinden, ohne alles noch mal zu hören…)

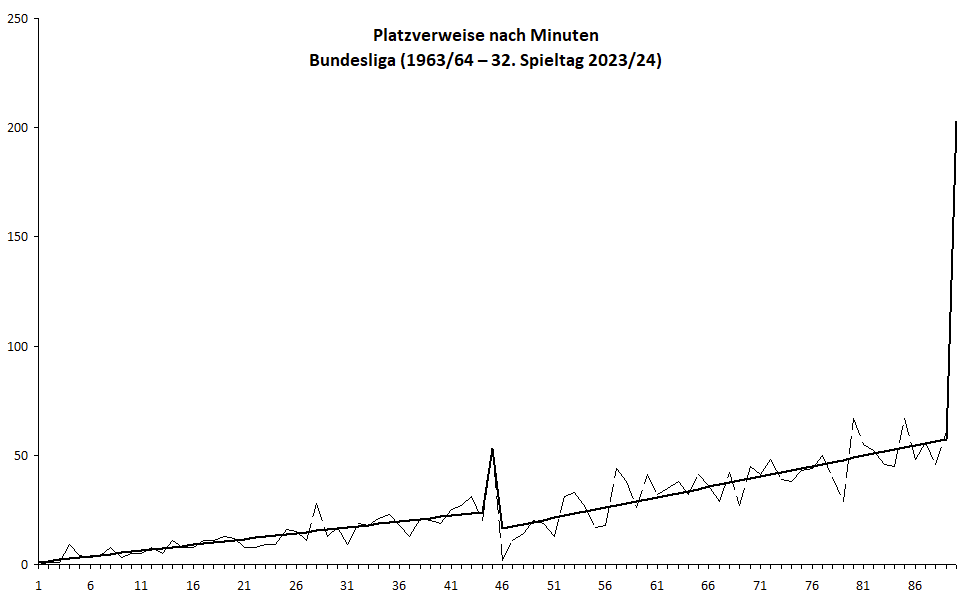

Um das zu untersuchen, kann man im ersten Schritt die Spielminuten ermitteln, die Mannschaften in Gleich-, Über- und Unterzahl verbracht haben und dazu die in der jeweiligen Konstellation erhaltenen Platzverweise ins Verhältnis setzen. @zaunpfahl hat jallerdings berechtigterweise darauf hingewiesen, dass die Platzverweis-Zeitpunkte innerhalb eines Spiels nicht gleichverteilt sind, sondern die Wahrscheinlichkeit mit wachsender Spieldauer ansteigt; die Platzverweis-Wahrscheinlichkeit in Unter- oder Überzahl ist also schon allein dehalb höher, weil diese Zeiträume systematisch später im Spiel liegen. Um das zu berücksichtigen, habe ich zunächst die Verteilung der Platzverweise nach Minuten ermittelt und ausgeglichen. (Die Peaks in der 45. und 90. Minute sind dringeblieben, da in meinen Daten die Nachspielzeiten nicht gesondert erfasst sind und diese Minuten also a priori länger dauern.)

Wenn man die ausgeglichenen Werte geeignet (= auf eine Gesamtsumme von 90) normiert und die Platzverweise ins Verhältnis zu den „gewichteten Minuten“ setzt, wird die zeitliche Verzerrung rausgerechnet.

Damit kommt man zu den folgenden Ergebnissen:

Erkenntnis: Auch nach Korrektur der zeitlichen Ungleichverteilung ist die empirische Wahrscheinlichkeit, einen Platzverweis zu kassieren, in eigener Überzahl deutlich höher als in Gleichzahl, aber auch auch in eigener Unterzahl noch nennenswert erhöht.

Was Ihr mit dieser statistischen Wahrheit anfangt, bleibt wie immer Euch überlassen ![]()

Hmm, interessant. Die erhöhte Wahrscheinlichkeit in eigener Überzahl rot zu bekommen kann teilweise trivial sein. Wenn zwei Spieler Rot bekommen, dann war der zweite ja in Überzahl.

Das Argument verstehe ich nicht so ganz.

Das ist zwar richtig (wenn nicht beide Spieler zum gleichen Team gehören), aber das sagt doch nichts über die Wahrscheinlichkeiten aus?

die würden in der gleichen minute rot bekommen, daher gab es nie eine Überzahl

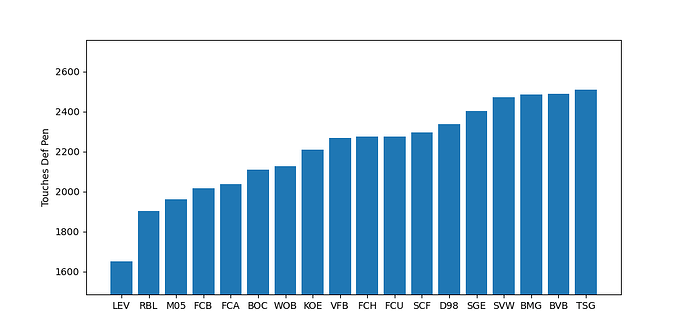

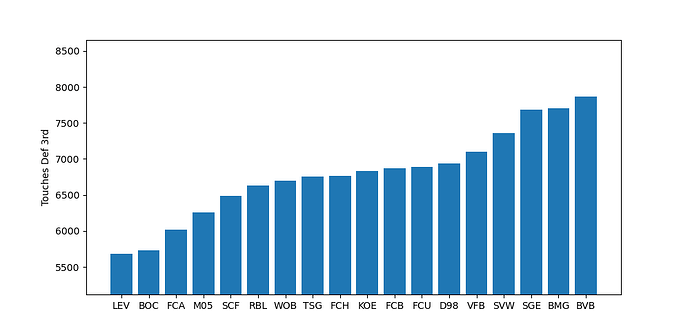

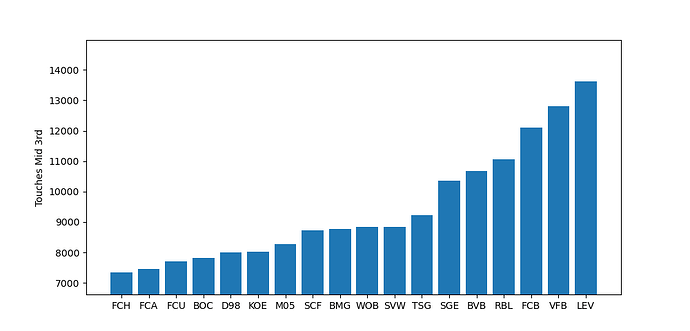

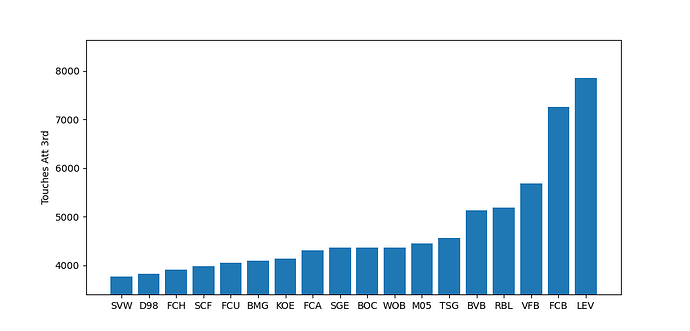

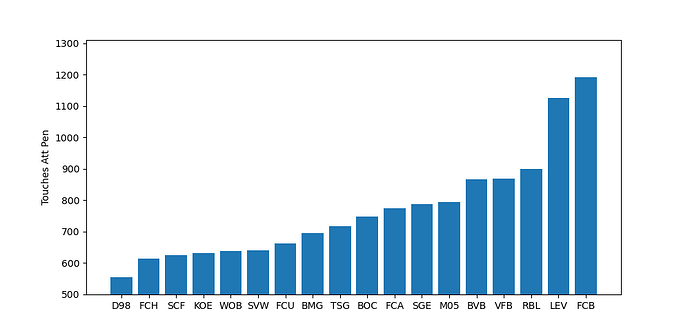

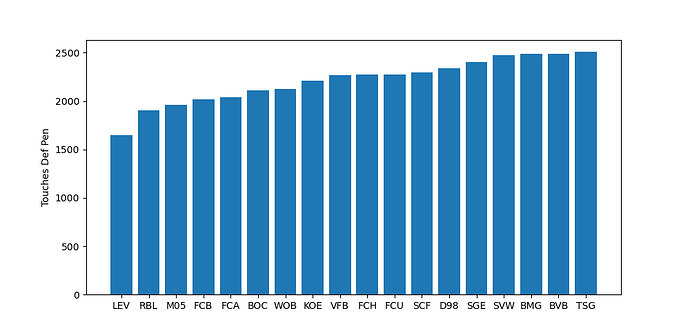

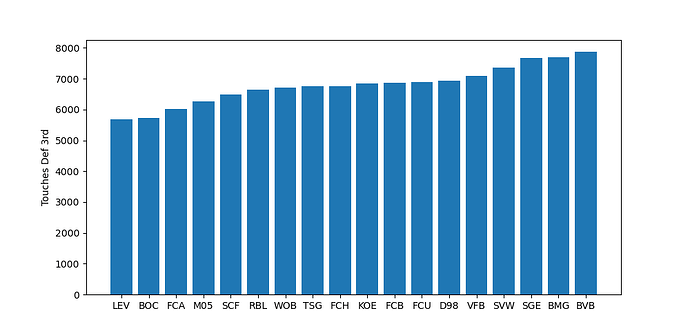

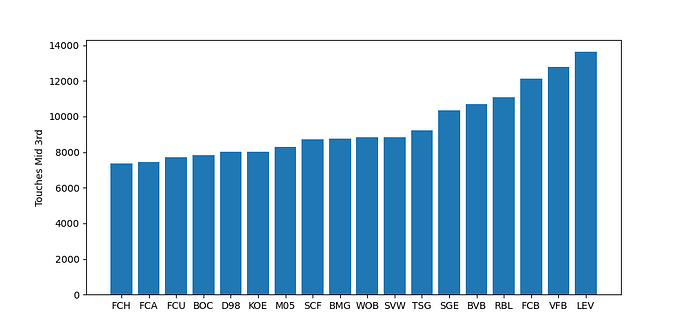

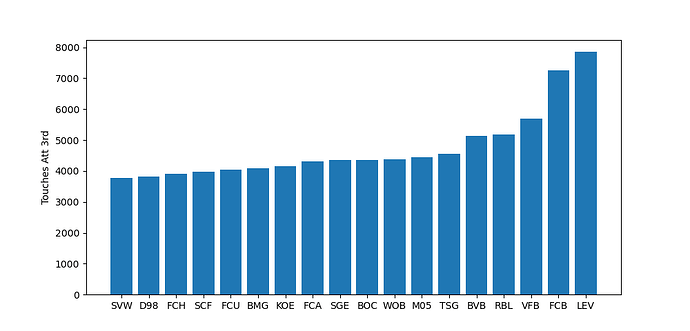

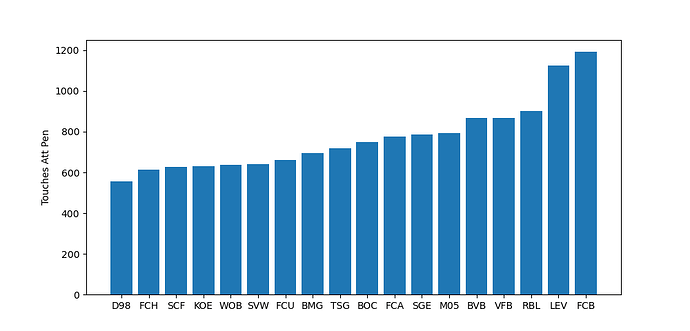

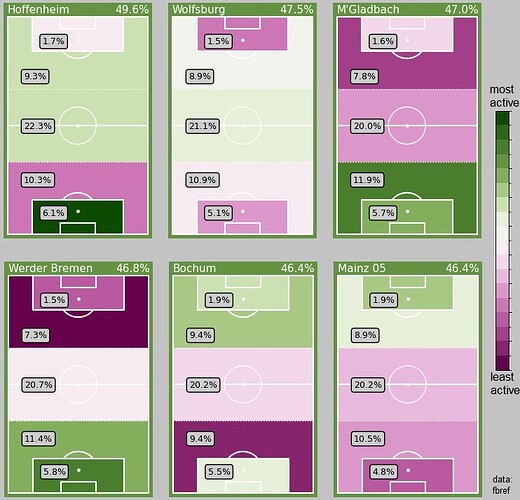

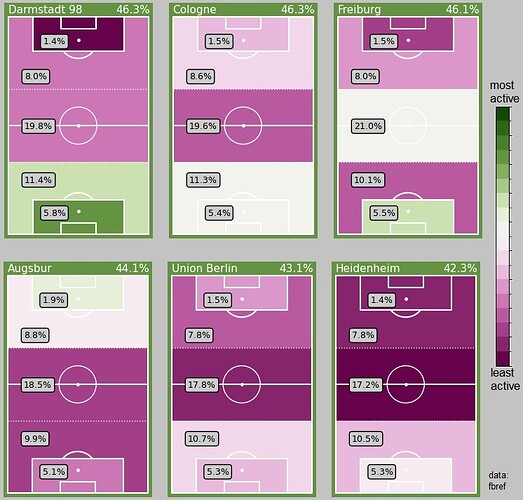

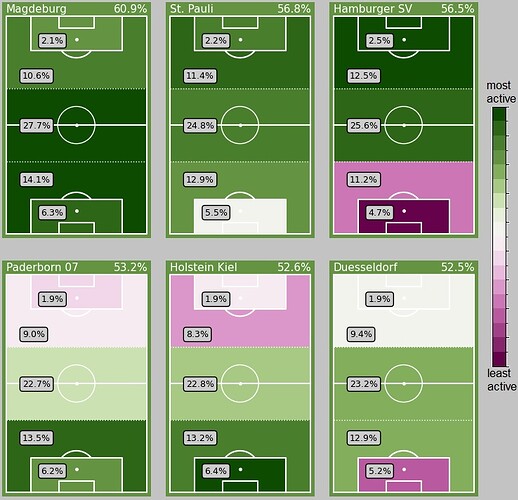

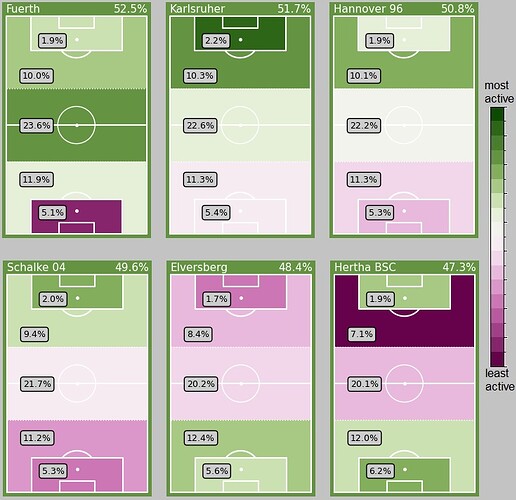

Auf Anfrage von @GNetzer hier mal die Touches aller Vereine in den verschiedenen Zonen des Spielfelds. Die Daten kommen von FBRef, nach dem 33. Spieltag 2023/24 (der letzte Spieltag fehlt also).

ACHTUNG: Die y-Achse sind für bessere Sichtbarkeit nicht bis Null dargestellt, das kann die Wahrnehmung aber verzerren. Unten sind noch einmal alle Graphen über die volle Skala dargestellt.

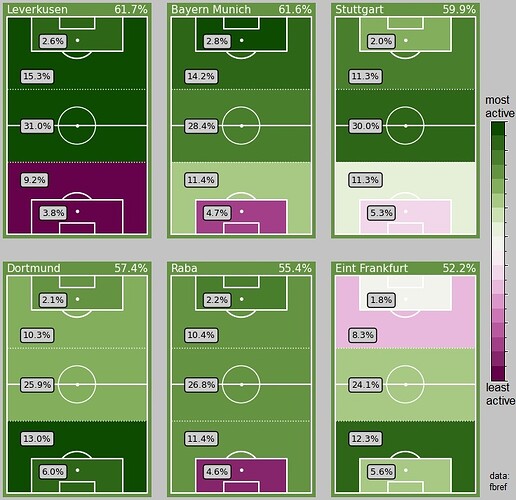

Finde es spannend, dass Leverkusen deutlich mehr Kontakte im Angriffsdrittel hat als Bayern, aber weniger im gegnerischen Strafraum. Leute mit Ahnung können da sicherlich Parallelen zur Spielweise der beiden Teams aufziehen, vermutlich aber auch wie die Gegner gegen sie spielen (tiefer block vs pressen?). Das gleiche in grün gilt auf für Stuttgart und RaBa.

Nochmal die selben Daten pro Team dargestellt, also in welchen Zonen die Teams welchen Anteil ihres Ballbesitzes haben. Die Farbgebung stellt den ligaweiten Vergleich pro Zone dar. Grüntöne: das Team gehört zu den oberen 50% in dieser Zone. Rot/Lilatöne: das Team gehört zu den unteren 50% in dieser Zone.

Nicht im Detail durchgesehen, aber „Ballbesitz im 2. Drittel“ korreliert recht gut mit der Abschlusstabelle…

Ich habe mich jetzt mal an einer Auswertung versucht. Folgende Methodik:

- Datengrundlage: Es werden nur Trainerwechsel innerhalb einer Saison berücksichtigt (also nicht in der Sommerpause). Der Cut für die Vorher-Nachher-Betrachtung ist die Entlassung des bisherigen Trainers – in den Nachher-Zeitraum fällt also auch die eventuelle Ablösung eines Interimstrainers durch einen neuen Cheftrainer oder des neuen Cheftrainers durch einen noch neueren.

Für die Ermittlung der Performance werden nur die Spiele in der jeweiligen Saison berücksichtigt. (Betrachtungen über die Sommerpause hinweg scheinen mir nicht sinnvoll.) Daher werden Trainerwechsel vor dem fünften und nach dem fünftletzten Saisonspiel nicht in die Auswertung einbezogen, damit man mindestens fünf Spiele vorher bzw. nachher als Vergleichsmaßstab hat.

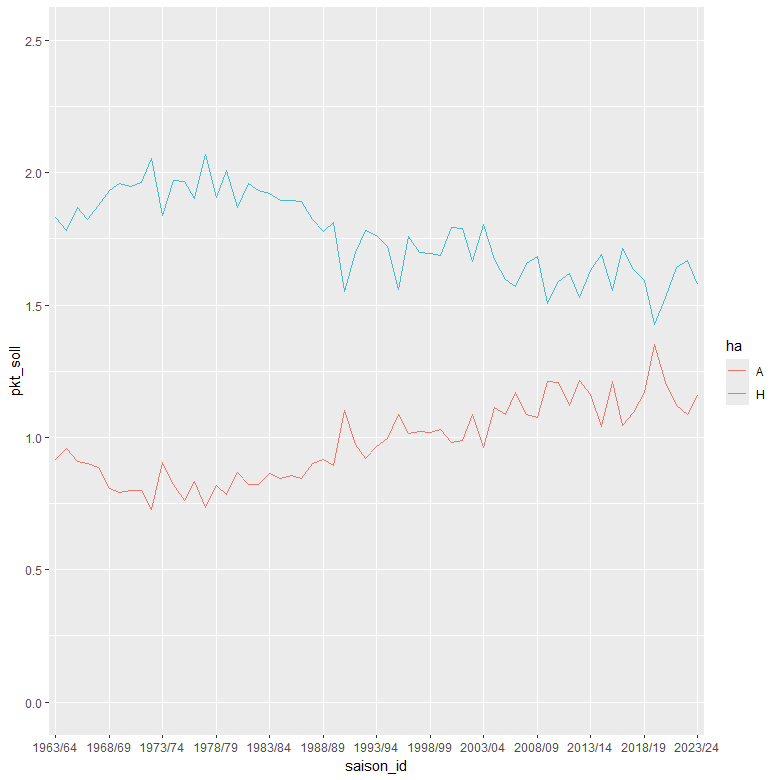

Unter diesen Voraussetzungen bleiben aus 61 Bundesliga-Saisons immerhin noch 372 Trainerwechsel als Datengrundlage übrig. - Performance: Als Messgröße habe ich das Verhältnis aus Ist- und Soll-Punktzahl auf Basis der Drei-Punkte-Wertung herangezogen. Die Ist-Punktzahl sollte selbsterklärend sein. Die Soll-Punktzahl ergibt sich auf Basis der in der Bundesliga historisch beobachteten Ergebniswahrscheinlichkeiten (Heimsieg ~ 50,2 %, Unentschieden ~ 25,6 %, Auswärtssieg ~ 24,2 %) als 1,762 für ein Heimspiel und 0,982 für ein Auswärtsspiel. Das berücksichtigt natürlich insbesondere nicht die Stärke der Gegner, aber das wäre a) schon ziemlich aufwändig und wird b) hoffentlich zumindest teilweise über die Mindestgröße des Beobachtungszeitraums kompensiert.

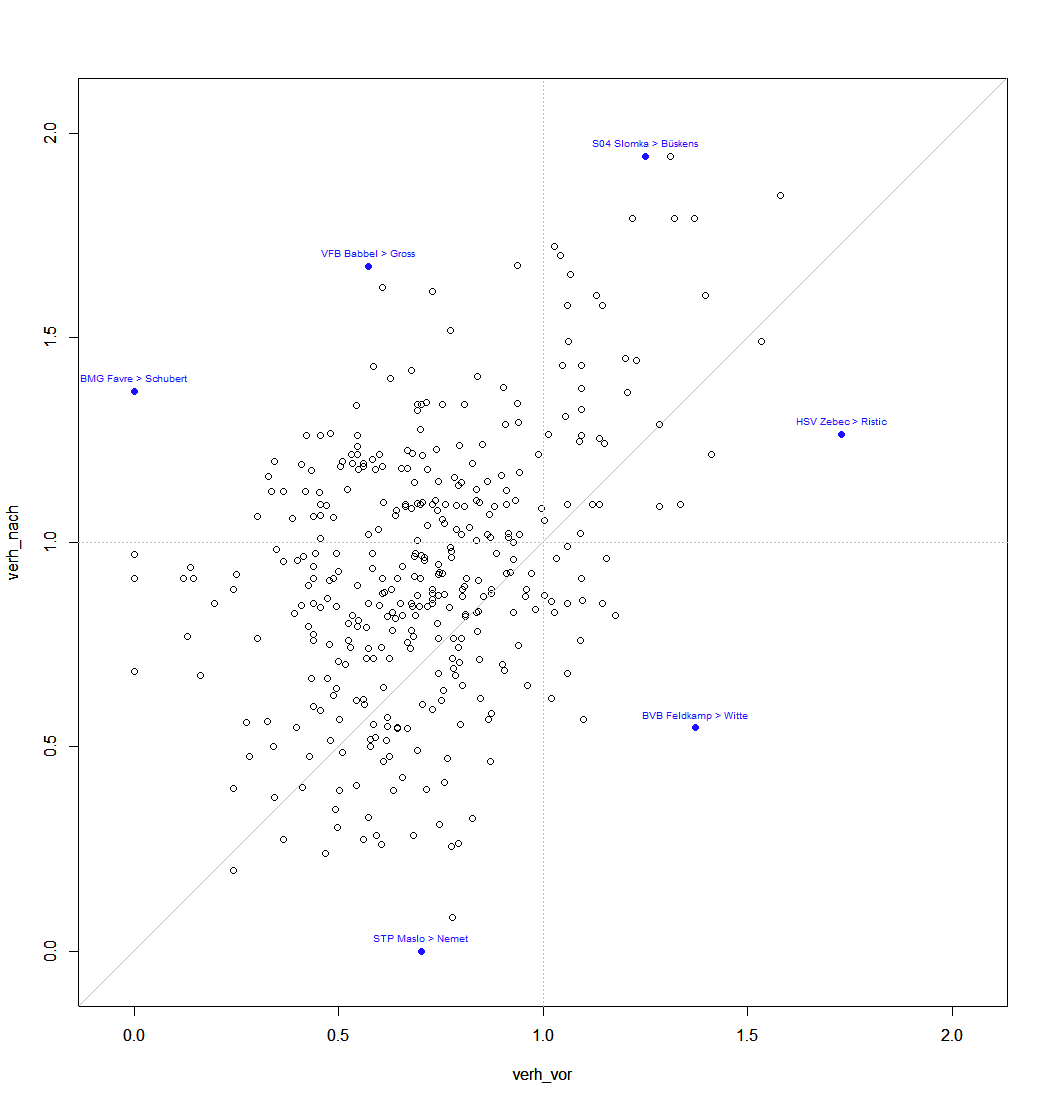

Unter diesen Prämissen kann man dann erst mal für jeden Trainerwechsel die Gesamt-Performance vorher und nachher vergleichen. (Beispiel: Bei einem Wechsel nach dem 12. Spieltag würde „vorher“ 12 und „nachher“ 22 Spiele umfassen.) Bei Teams mit mehr als einem Trainerwechsel pro Saison sind dann im Vorher- bzw. Nachher-Zeitraum die jeweils anderen Trainerwechsel enthalten. Dann bekommt man folgendes Bild (ein paar markante Punkte habe ich mal beschriftet):

Man erkennt, dass immerhin die meisten Datenpunkte oberhalb der Diagonalen liegen, sich die Performance also immerhin in den meisten Fällen irgendwie verbessert hat.

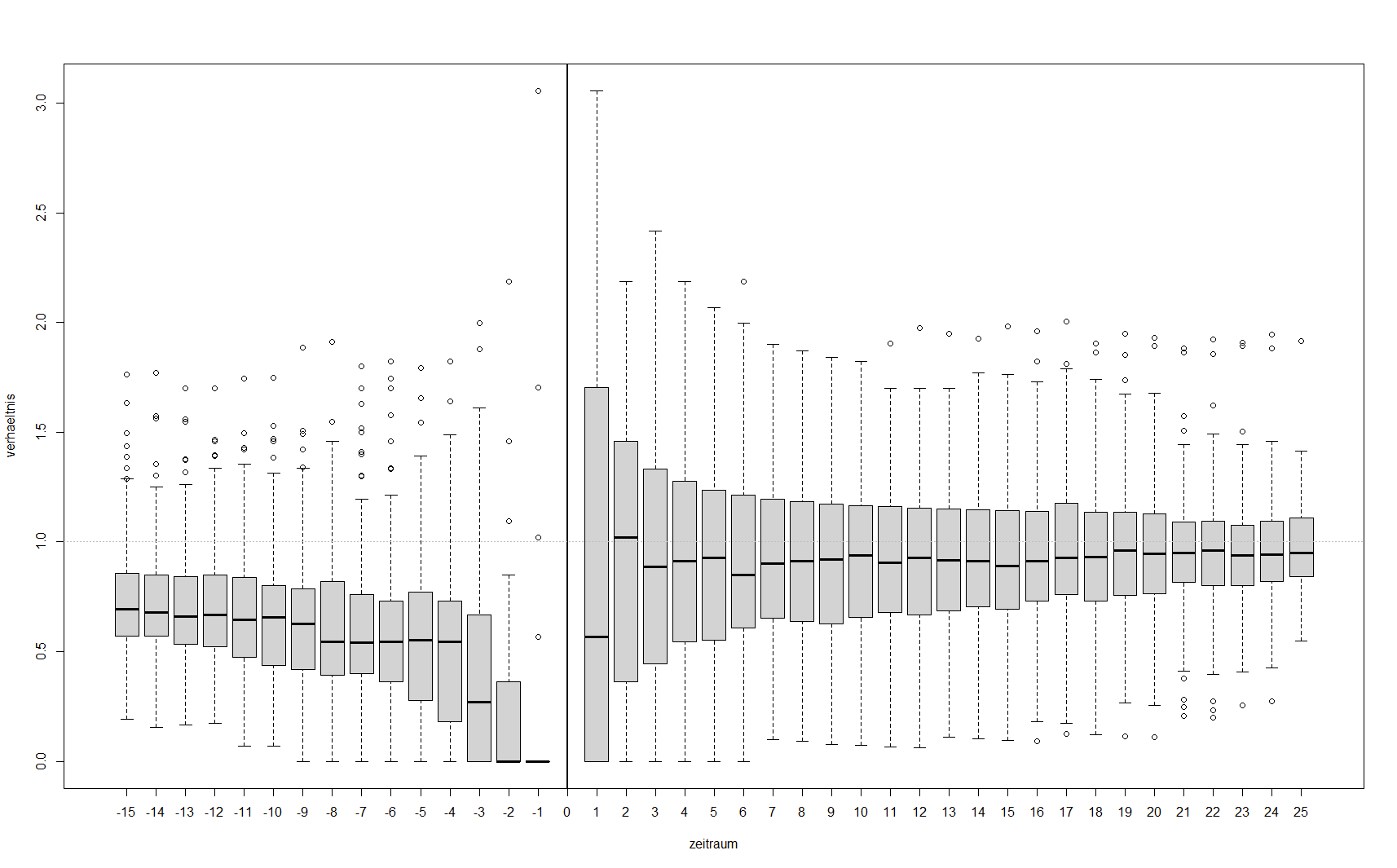

Im nächsten Schritt kann man sich dann auch anschauen, wie sich die Performance im Zeitablauf bis zum und ab dem Trainerwechsel entwickelt hat:

Achtung: Dabei sind als Grundmenge die oben erwähnten 372 Trainerwechsel berücksichtigt (die Boxplots von -5 bis +5 beruhen also auf derselben Grundgesamtheit), bis -6 und ab +6 aber logischerweise nur noch die Trainerwechsel, die spät bzw. früh genug stattgefunden haben, also eine nach außen abnehmende Anzahl (-15 ~ 251, +25 ~ 60).

Erkenntnis: Die Performance vor dem Trainerwechsel ist deutlich unterdurchschnittlich mit zum Wechselzeitpunkt hin negativer Tendenz, nach dem Trainerwechsel im Median nur noch leicht unterdurchschnittlich, aber ohne klaren Trend.

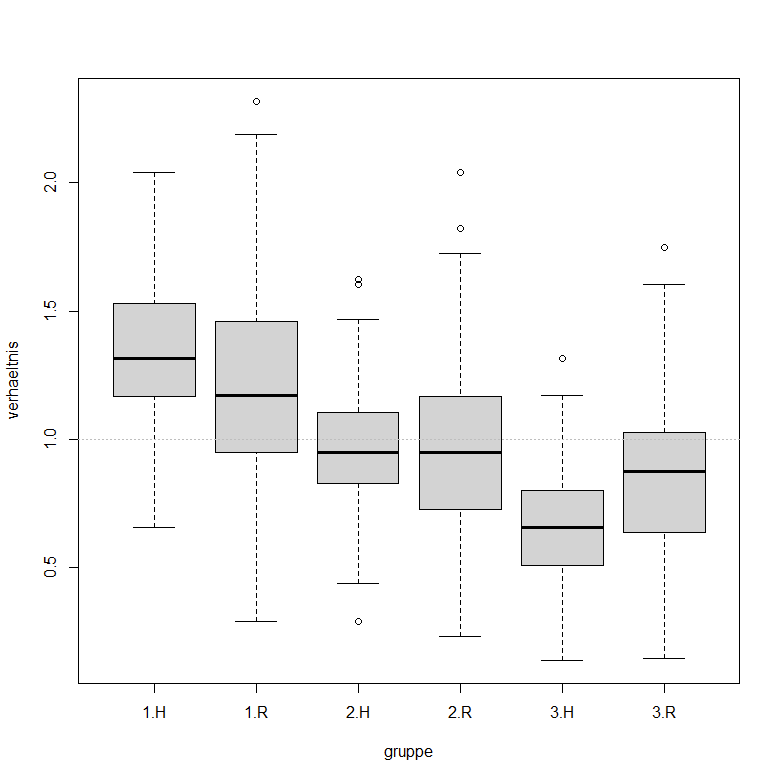

Da habe ich mal eine ganz rudimentäre Auswertung probiert: Ich habe die Saisons betrachtet, bei denen zwischen dem letzten Spiel im alten und dem ersten Spiel im neuen Jahr mindestens drei Wochen lagen (das sind 54 von 61). Dann habe ich für jeden Verein nach der obigen Methodik die Performance vor und nach der Winterpause verglichen. Zusätzlich habe ich die Vereine auf Basis der Winterpausentabelle in drei Gruppen eingeteilt (1 = die ersten Sechs, 2 = das Mittelfeld, 3 = die letzten Sechs).

Dann ergibt sich die folgende kleine Grafik (H = „Hinrunde“ = vor der Winterpause, R = „Rückrunde“ = nach der Winterpause):

Offenbar scheint nach der Winterpause generell die vielbesungene Regression zur Mitte stattzufinden: Die obere Gruppe performt eher etwas schlechter, die untere eher etwas besser und bei der mittleren ändert sich nicht viel – das alles allerdings bei sichtbar erhöhter Varianz. Ob das eine Antwort auf die ursprüngliche Frage darstellt, muss der Fragensteller selbst entscheiden…

Erklärungsansätze und Verbesserungsvorschläge aller Art werden gerne entgegengenommen – vielleicht hat @zaunpfahl ja eine Idee, wo ich noch was normieren könnte ![]()

Wenn du so fragst, immer ![]() Du nimmst in der Bundesliga eine konstante „historische Ergebniswahrscheinlichkeit“ an. Ich könnte mir aber auch vorstellen, dass sich die über die Jahre verändert hat? Man müsste das mal über einen Zeitstrahl darstellen und schauen ob man da die Normierung im Laufe der Jahre anpassen sollte. Gehe jedoch davon aus, dass der Effekt eher klein sein wird im Vergleich zum Rauschen der Datenlage.

Du nimmst in der Bundesliga eine konstante „historische Ergebniswahrscheinlichkeit“ an. Ich könnte mir aber auch vorstellen, dass sich die über die Jahre verändert hat? Man müsste das mal über einen Zeitstrahl darstellen und schauen ob man da die Normierung im Laufe der Jahre anpassen sollte. Gehe jedoch davon aus, dass der Effekt eher klein sein wird im Vergleich zum Rauschen der Datenlage.

Aber Spaß bei Seite: sehr coole Auswertung, vielen vielen Dank! Interessante Punkte die ich da rauszulesen glaube:

- Trainer werden zu über 75% nach einer Niederlage Entlassen (nein, doch, ohhh!)

- das zweite Spiel unter dem neuen Trainer ist anscheinend besser als das erste? Oder liegt das ggf daran, dass das erste Spiel gerne noch ein Interimstrainer war?

- im Sinne der originalen Fragen würde ich mich hier noch weiter aus dem Fenster lehnen: Es gibt einen deutlichen Trainer-Effekt und der der ist vorallem langfristig. Wir reden hier nicht von 3-4 guten Spielen und dann fällt es wieder runter auf das vorherige Niveau und wir müssen den nächsten Trainer einstellen. Eigentlich bleibt es häufig langfristig besser als vorher. Natürlich muss man aufpassen, da die Streuung nach dem Trainerwechsel deutlich größer ist und es auch ein bischen eine self-fullfilling prophecy, da wir vorher auf Trainer gucken die bestimmt schlecht waren und danach auf welche die im Schnitt „mittelgut“ sind.

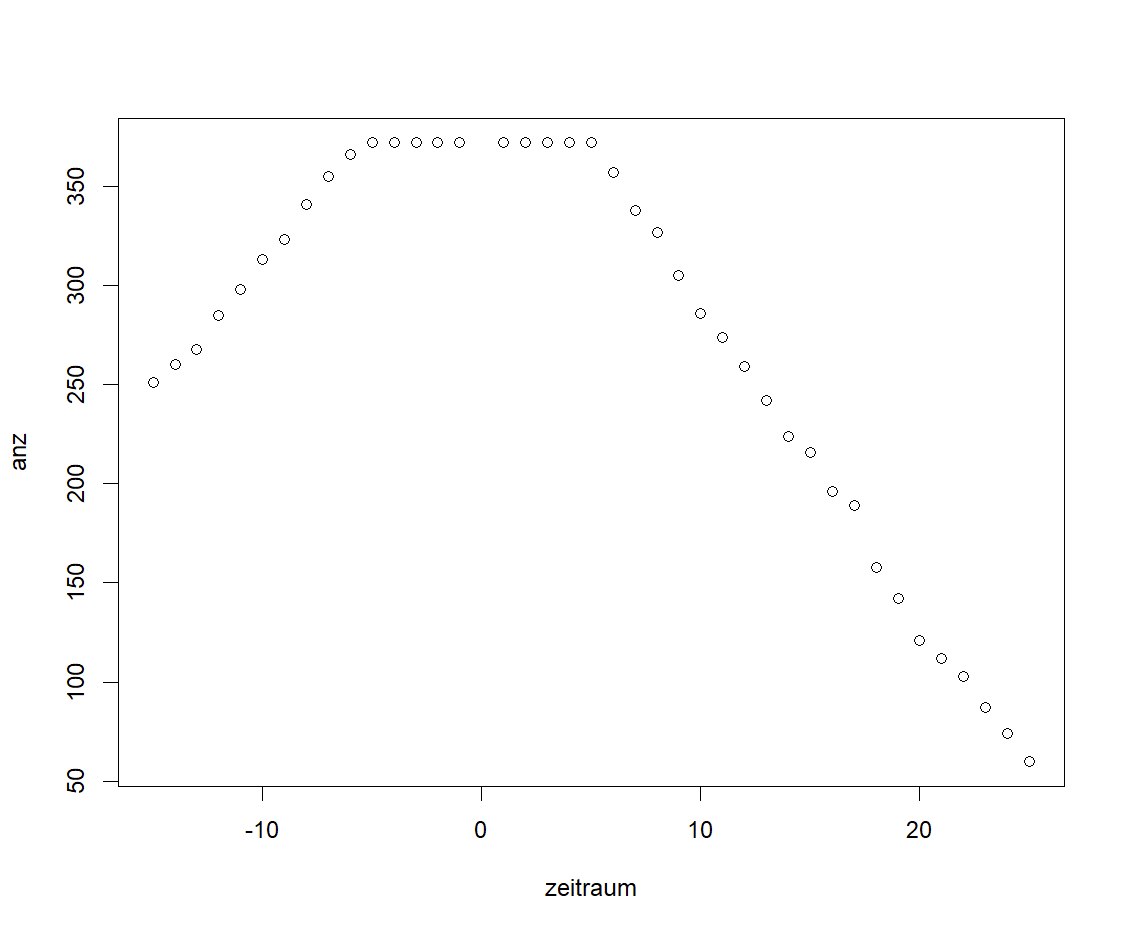

Wenn man die Augen aber fest zusammenkneift kann man einen leichten Trend nach oben um den Spieltag +16 herum erahnen. Ggf wurden zu dem Zeitpunkt die „schlechten neuen Trainer“ schon wieder entlassen und wer jetzt noch dabei ist muss besser gewesen sein als vorher? @Dirk: könntest du eine Grafik „Stichprobengröße vs zeitraum“ machen? Wird schwer die zu deuten weil ja auch die Saison irgendwann aufhört, aber vlt haben wir irgendwo einen Knick? Ggf müsste man die Statistik dann nur mit Fällen machen bei denen die Trainer in der Hinrunde entlassen wurden, damit man eben nicht ins Saisonende reinläuft.

Danke noch einmal für diese wundertolle Auswertung und auch an Max für die Frage ![]() Ich zumindest mag diesen Thread hier sehr

Ich zumindest mag diesen Thread hier sehr

Ich würde behaupten, das ist das einzige was diese Auswertung messen kann. Max ursprüngliche Frage ist mMn sehr schwer zu bemessen, da ja ALLE Teams eine Winterpause haben, dh wenn es einen Effekt im Mittel gibt, haben den alle Teams. Nicht nur die im Tabellenkeller, auch die Spitzenteams können sich im Trainingslager verbessern. Wenn alle also im Schnitt besser werden, dann ändert sich nichts, wenn man sich Punkte oder so anschaut, da ja nicht beide gewinnen können.

Daher müsste man als „Observable“ auf Werte verzichten die in „Konkurenz“ mit der Leistung des Gegners stehen (Punkte, xG, Ballbesitz usw) und „gegnerunabhängige“ finden. Die wird es natürlich niemals geben, aber Laufleistung, Passquote, Disziplin (aka Karten) wären auf jeden Fall unabhängiger. Ob sie jedoch das widerspiegeln was wir wissen wollen (wie gut ist ein Team?) ist wieder ein anderes Problem. Mir fällt auf die Schnelle kein Weg ein diese These zu überprüfen, außer die durchschnittlichen Kickernoten zum eigentliche Spiel zu plotten und selbst das ist ein grausames Maß und sollte bitte niemand tun (außer zu Halloween).

Voilà…

Sind offenbar tatsächlich relativ viele Wechsel zwischen Hin- und Rückrunde, zwischen 17 und 18 ist ein deutlicher Abfall.

Das ist tatsächlich ein etwas stärkerer Trend, als ich vermutet hätte. (Mir war bekannt, dass sich im Europapokal der Einfluss des Heimvorteils über die Jahre stark abgeschwächt hat. Für die Bundesliga hatte ich nicht an einen solchen Effekt geglaubt.) Aber qualitativ dürfte es am Ergebnis tatsächlich nicht wahnsinnig viel ändern.

Interessante Ausarbeitung, es gibt dazu tatsächlich auch einige Studien. Die allermeisten Studien finden keinen Trainereffekt. In einem The Athletic Artikel über den generellen Einfluss von Trainern gibt es auch einen Abschnitt zum Trainereffekt, in dem sie unter anderem auf eine niederländische Studie verweisen. In der Einleitung vom Studienbericht zählen sie selber auch einige andere Studien auf, wenn man sich einen Überblick über mehrere Studien verschaffen will. In der Studie selbst haben sie Trainerwechsel mit ähnlichen erfolgslosen Phasen verglichen, in denen der Trainer nicht gewechselt wurde. Theoretisch hätte ein Ergebnisumschwung auch unter dem bisherigen Trainer kommen können, da vielleicht bestimmte Spieler zurückgekehrt sind oder leichtere Gegner anstanden. Wie viele der anderen Studien kamen sie auch zu dem Ergebnis, dass es allgemein keinen Trainereffekt gibt. Die Studie ist frei verfügbar, also wenn Interesse daran besteht kann sich jeder das durchlesen.

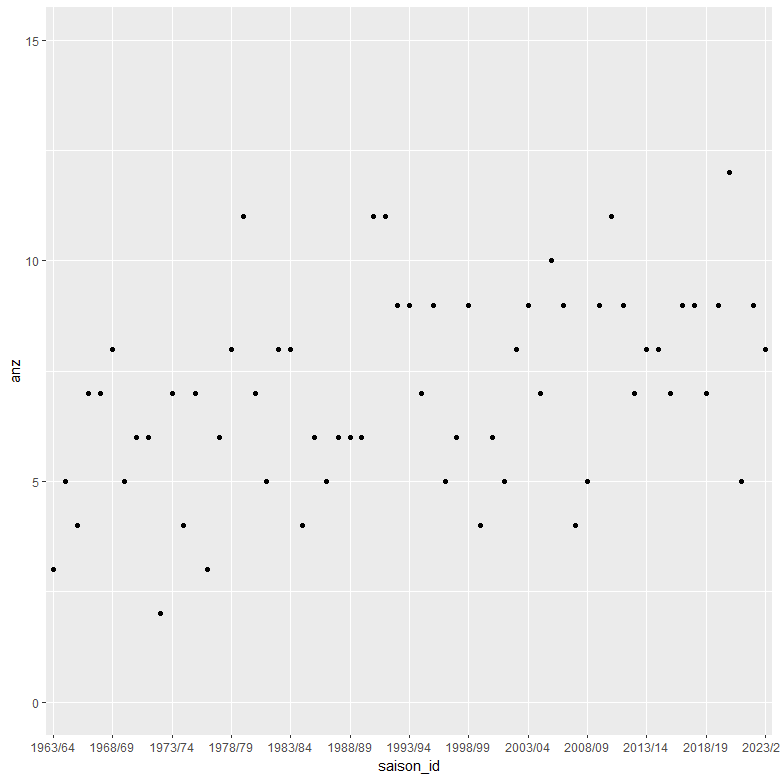

So etwas wäre natürlich ein massiver Mehrwertaufwand gewesen solche schlechte Phasen ohne Trainerwechsel zu identifizieren. Ich kann mir vorstellen, dass es auch so schon einiges an Aufwand war, deshalb Chapeau für die Ausarbeitung. Für die gesamte Bundesliga-Historie habe ich dazu auch noch nichts gesehen. Aus Interesse, da du die Daten dazu hast, sind es mittlerweile tatsächlich mehr Trainerwechsel als früher oder ist das ein Wahrnehmungsfehler?

Wobei ich das so interpretieren würde, dass es einen Sprung Ende der 80er/Anfang der 90er gab, seitdem ist es einigermaßen konstant mit ein bisschen Varianz drin. 9 Trainerwechsel pro Saison scheinen der Standard seitdem zu sein. Selten mehr, ab und zu ein paar weniger Trainerwechsel. 20/21 musste ich kurz mal nachgucken, was da los war mit den 14 Trainerwechseln. Die Trainerwechsel bei Mainz 05 habe ich auf dem Schirm gehabt, aber ich habe vergessen gehabt, dass Schalke von Wagner zu Baum zu Stevens(Interimstrainer für zwei Spiele) zu Gross zu Grammozis gegangen ist. Dazu das eine Saisonspiel von Thomas Schaaf am Saisonende. Auch wenn das glaube ich nicht mit reinzählt, war das auch noch die Saison, in der am Ende die Top 6 alle neue Trainer bekommen haben. Was für eine verrückte Saison haha.

Ich habe das Ganze jetzt noch mal – extra für @zaunpfahl natürlich – in einer interaktiven Variante für alle Bundesliga-Saisons gebastelt.

(Hat Tip an @AicMax für den Hinweis auf Flourish)